Über die fragwürdigen Qualitäten von Klimamodellen und Temperaturprognosen haben wir hier im Blog bereits mehrfach in Einzelbeiträgen berichtet (Artikelübersicht hier). Wir wollen das Thema nun in einer kleinen Serie vertiefen und hierzu einen kleinen Streifzug durch die aktuelle Literatur unternehmen. Sind die millionenschweren Rechenkästen ihre hohen Investitionskosten wert oder gibt es möglicherweise Gründe, sich zunächst auf die grundlegende Klärung des darin verwendeten Formelwerks zu konzentrieren? Kann man den Ergebnissen der Klimamodellierung uneingeschränkt vertrauen oder ist hierzu religiöse Überzeugung von Nöten?

Der bekannte Mathematiker und Chaosforscher Heinz-Otto Peitgen wurde 2006 in einem Spiegel-Interview gefragt, ob sich denn das Klima überhaupt modellieren ließe. Pleitgen, der mittlerweile Präsident der Bremer Jacobs University ist, antwortete damals:

„Jetzt reden wir von Glaubenssachen. Es gibt Leute, die glauben – und viele von denen sitzen in hoch bezahlten Positionen in sehr bedeutenden Forschungszentren -, dass man das Klima modellieren kann. Ich zähle zu denen, die das nicht glauben. Ich halte es für möglich, dass sich die mittlere Erwärmung der Ozeane in 50 Jahren mit einem bestimmten Fehler vorausberechnen lässt. Aber welche Wirkungen das auf das Klima hat, das ist eine ganz andere Geschichte.“

Mit dieser skeptischen Sichtweise ist Peitgen nicht allein. Im Jahr 2011 erschien im Journal of Forecasting eine Studie, in der die Ergebnisse von Klimamodellen gegen den Verlauf von Zufallsbewegungen („random walk“) verglichen wurden. Das erschreckende Resultat: Die getesteten Klimamodelle schnitten schlechter ab als die Zufallsbewegungen (siehe Ross McKitrick’s Artikel in der Financial Post, bzw. Beiträge auf WUWT und EIKE). Andrew Montford schlug aufgrund der mageren Leistungen der Klimamodelle vor, diese künftig als „Protomodelle“ zu bezeichnen, damit sie von effektiveren, wirklich prädiktiven Modellen unterschieden werden können. Auf diese Weise würden die großen Unsicherheiten der Klimamodelle in der Öffentlichkeit Erinnerung gehalten, was insbesondere für politische Entscheidungsträger wichtig ist.

Bei einem Treffen von Klimawissenschaftlern, das im Oktober 2011 in Boulder, Colorado, stattfand, zeigte sich, dass die Ergebnisse der diversen verwendeten globalen und regionalen Klimamodelle stark streuten. Die Gründe für diese Diskrepanzen wären allerdings noch zu schlecht verstanden und würden in der Diskussion noch zu wenig berücksichtigt geschweige denn kommuniziert. Diese Schlussfolgerung des Workshops wurde in einem Artikel der geophysikalischen Fachzeitung Eos festgehalten (siehe Beitrag von Roger Pielke, Sr.). Roger Pielke, Sr. weist zudem darauf hin, dass Modelle erst dann als glaubwürdig und verlässlich eingestuft werden können, wenn sie die Klimaentwicklung der Vergangenheit reproduzieren könnten. Bislang sind die Modelle jedoch diesen Beweis schuldig geblieben, insbesondere wenn man regionale Entwicklungen im Maßstab von einzelnen Jahren bis zu mehreren Jahrzehnten als Test heranzieht.

Noch immer sind die Vorgänge in der Atmosphäre offensichtlich viel zu komplex, als dass sie von Computern in realistischer Weise modelliert werden könnten. Einen Überblick zu diesem Problem gibt zum Beispiel Tim Ball in seinem Blog.

Natürlich möchte man von all diesen Schwächen der Klimamodelle am liebsten gar nichts hören, wenn man Anhänger der Klimakatastrophe ist. Daher geht die Modelliererzunft in der Öffentlichkeit gerne über diese Schwierigkeiten hinweg. Es sei alles viel zu kompliziert und als Normalmensch könne man das sowieso nicht verstehen. Trust me, I am a Doctor!

Die Öffentlichkeit ist mittlerweile jedoch hellhörig geworden. In einer kürzlich veröffentlichten Studie wertete Karen Akerlof mit einigen Kollegen die vier wichtigsten nationalen Tageszeitungen der USA für den Zeitraum von 1998 bis 2010 und prüfte die Berichterstattung zum Thema Klimammodelle. Es zeigte sich, dass im Schnitt doppelt so viele negative Kommentare über die Leistungsfähigkeit von Klimamodellen vorkamen wie positive. In Umfragen gaben zudem knapp zwei Drittel der US-Bürger an, dass Klimamodelle entweder zu ungenau sind, um die Zukunft vorherzusagen, oder dass sie nicht wissen, ob man ihnen vertrauen kann.

Und was für Schlüsse zog das Team um Akerlof daraus? Der ORF berichtete die überraschende Sichtweise:

Harald Lesch ist gelernter Astrophysiker und obendrauf noch ein äußerst begabter Vortragender, der komplexe Sachverhalte in verständlicher Weise erklären kann. Wenn Lesch gut in Form ist, macht es richtig Spass, ihm bei seinen Ausführungen zu lauschen. Seine mitreißende Art hat wohl 2008 auch das ZDF bewogen, ihm die Führung des Wissenschaftsmagazins Abenteuer Forschung zu übertragen. Das Nachsehen hatte damals der etwas steifere Joachim Bublath, der diese Sendung viele Jahre moderierte und kurzerhand in Rente geschickt wurde. Bublath hatte 2007 eine

Harald Lesch ist gelernter Astrophysiker und obendrauf noch ein äußerst begabter Vortragender, der komplexe Sachverhalte in verständlicher Weise erklären kann. Wenn Lesch gut in Form ist, macht es richtig Spass, ihm bei seinen Ausführungen zu lauschen. Seine mitreißende Art hat wohl 2008 auch das ZDF bewogen, ihm die Führung des Wissenschaftsmagazins Abenteuer Forschung zu übertragen. Das Nachsehen hatte damals der etwas steifere Joachim Bublath, der diese Sendung viele Jahre moderierte und kurzerhand in Rente geschickt wurde. Bublath hatte 2007 eine  „Liegt das Paradies auf dem Grund des Persischen Golfes? (…) Der Winnender Technikprofessor Norbert Buchner und sein Sohn Elmar, ein Geologe, der Dozent an der Universität Hohenheim ist, haben sich jahrelang mit der Frage nach der Wiege der Menschheit und dem Weg ins Paradies beschäftigt. Der populärwissenschaftliche Lösungsvorschlag des Rätsels liegt seit Neuestem als 262-seitiges Buch vor (..) das sich in recht anschaulicher Weise auf die Suche nach dem nachweislich wahren Kern der Mythen über die Sintflut und das verlorene Paradies macht. (…) Entstanden ist ein Werk, das die Mythen über die Sintflut durchaus nachvollziehbar mit geografischen und klimatologischen Erkenntnissen in Übereinstimmung bringt. Die Sintflut beschreibt demnach die Folgen jener klimatischen Veränderungen, die in der Zeit zwischen 18 000 und 9000 Jahre vor Christi Geburt dafür gesorgt haben, dass die zunächst fruchtbaren Ebenen auf dem Grund des heutigen Persischen Golfes nach und nach überflutet wurden. In jenem Zeitraum ist (…) der Meeresspiegel um 130 Meter angestiegen (…) Ganze Siedlungen im Gebiet der Wiege unserer Kultur, dort, wo die Autoren auch jenes Fleckchen Erde vermuten, das dann als Garten Eden in die Mythen einging, liegen unter Wasser begraben. (…)“

„Liegt das Paradies auf dem Grund des Persischen Golfes? (…) Der Winnender Technikprofessor Norbert Buchner und sein Sohn Elmar, ein Geologe, der Dozent an der Universität Hohenheim ist, haben sich jahrelang mit der Frage nach der Wiege der Menschheit und dem Weg ins Paradies beschäftigt. Der populärwissenschaftliche Lösungsvorschlag des Rätsels liegt seit Neuestem als 262-seitiges Buch vor (..) das sich in recht anschaulicher Weise auf die Suche nach dem nachweislich wahren Kern der Mythen über die Sintflut und das verlorene Paradies macht. (…) Entstanden ist ein Werk, das die Mythen über die Sintflut durchaus nachvollziehbar mit geografischen und klimatologischen Erkenntnissen in Übereinstimmung bringt. Die Sintflut beschreibt demnach die Folgen jener klimatischen Veränderungen, die in der Zeit zwischen 18 000 und 9000 Jahre vor Christi Geburt dafür gesorgt haben, dass die zunächst fruchtbaren Ebenen auf dem Grund des heutigen Persischen Golfes nach und nach überflutet wurden. In jenem Zeitraum ist (…) der Meeresspiegel um 130 Meter angestiegen (…) Ganze Siedlungen im Gebiet der Wiege unserer Kultur, dort, wo die Autoren auch jenes Fleckchen Erde vermuten, das dann als Garten Eden in die Mythen einging, liegen unter Wasser begraben. (…)“

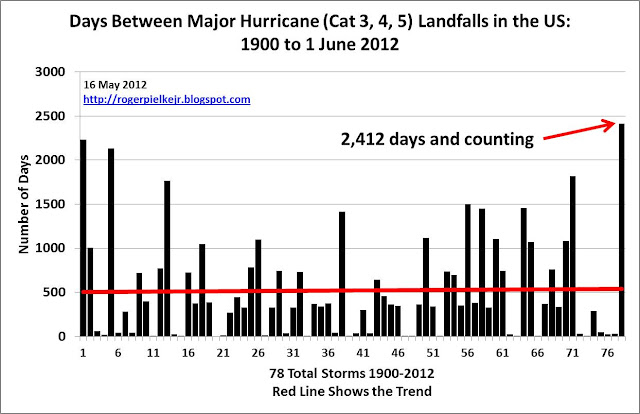

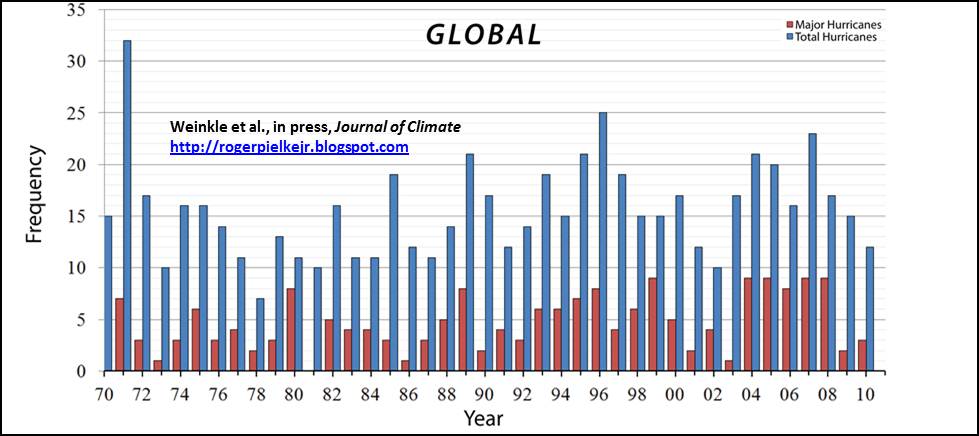

In den USA wird man langsam unruhig. Noch vor wenigen Jahren hatte der IPCC vorhergesagt, dass die Hurrikane durch die Klimaerwärmung immer häufiger und auch stärker werden würden. Aber die Realität hat offenbar andere Pläne: Seit nunmehr fast 2500 Tagen hat das Land jetzt keinen Monster-Hurrikan mehr erlebt. Das ist absoluter Rekord seit Beginn des 20. Jahrhunderts. Noch nie musste man in dieser Zeit länger auf einen starken Hurrikan der Kategorie 3-5 warten (Abbildung 1). Dies berichtete kürzlich

In den USA wird man langsam unruhig. Noch vor wenigen Jahren hatte der IPCC vorhergesagt, dass die Hurrikane durch die Klimaerwärmung immer häufiger und auch stärker werden würden. Aber die Realität hat offenbar andere Pläne: Seit nunmehr fast 2500 Tagen hat das Land jetzt keinen Monster-Hurrikan mehr erlebt. Das ist absoluter Rekord seit Beginn des 20. Jahrhunderts. Noch nie musste man in dieser Zeit länger auf einen starken Hurrikan der Kategorie 3-5 warten (Abbildung 1). Dies berichtete kürzlich

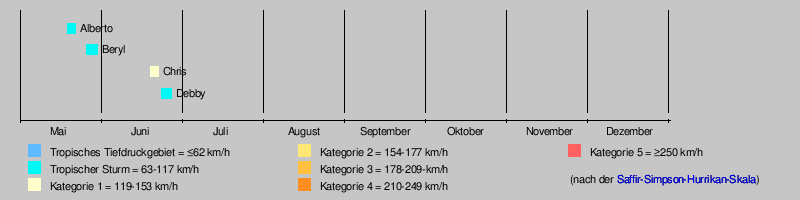

Mitte Mai 2012 begann die neue Hurrikan-Saison. Im

Mitte Mai 2012 begann die neue Hurrikan-Saison. Im

Das Deutsche GeoForschungsZentrum (GFZ) ist das nationale Forschungszentrum für Geowissenschaften in Deutschland. Es befindet sich im Wissenschaftspark Albert Einstein auf dem Potsdamer Telegrafenberg. Das GFZ umfasst

Das Deutsche GeoForschungsZentrum (GFZ) ist das nationale Forschungszentrum für Geowissenschaften in Deutschland. Es befindet sich im Wissenschaftspark Albert Einstein auf dem Potsdamer Telegrafenberg. Das GFZ umfasst  Wer die Welt in die Kategorien Schwarz und Weiß aufteilt, liegt zwangsläufig falsch. Denn zwischen diesen beiden Extremen gibt es nicht nur einige, sondern beliebig viele Graustufen. Diese uralte Erkenntnis trifft auch auf die Klimaforschung zu. […] Da gibt es auf der einen Seite die sogenannten Klimaskeptiker […]. Das andere Extrem sind diejenigen, die in lebhaften Farben Katastrophen zeichnen […]. Wie so oft liegt die Realität zwischen den Extremen. […]

Wer die Welt in die Kategorien Schwarz und Weiß aufteilt, liegt zwangsläufig falsch. Denn zwischen diesen beiden Extremen gibt es nicht nur einige, sondern beliebig viele Graustufen. Diese uralte Erkenntnis trifft auch auf die Klimaforschung zu. […] Da gibt es auf der einen Seite die sogenannten Klimaskeptiker […]. Das andere Extrem sind diejenigen, die in lebhaften Farben Katastrophen zeichnen […]. Wie so oft liegt die Realität zwischen den Extremen. […]  Vor einigen Tagen unterbrach das führende klimaskeptische Blog Watts Up With That? (WUWT) seine sonst so emsige Tätigkeit. Wo im Normalbetrieb jeden Tag eine ganze Hand voll neuer Blogartikel erschienen, herrschte plötzlich lähmende Inaktivität. Der Betreiber der Webseite, der Meteorologe Anthony Watts, kündigte eine wichtige Pressemitteilung für den Abend des 29. Juli europäischer Zeit an. Die Gerüchteküche brodelte und die Vermutungen gingen in die verschiedensten Richtungen. Hoffentlich handelte es sich nicht um Anthony’s Gesundheit. Waren es vielleicht juristische Vorgänge im Hintergrund, die WUWT zum Stop zwangen? Nein, keines von beidem, beruhigte Anthony die Blogosphäre vorab. Aber man müsse noch Geduld haben.

Vor einigen Tagen unterbrach das führende klimaskeptische Blog Watts Up With That? (WUWT) seine sonst so emsige Tätigkeit. Wo im Normalbetrieb jeden Tag eine ganze Hand voll neuer Blogartikel erschienen, herrschte plötzlich lähmende Inaktivität. Der Betreiber der Webseite, der Meteorologe Anthony Watts, kündigte eine wichtige Pressemitteilung für den Abend des 29. Juli europäischer Zeit an. Die Gerüchteküche brodelte und die Vermutungen gingen in die verschiedensten Richtungen. Hoffentlich handelte es sich nicht um Anthony’s Gesundheit. Waren es vielleicht juristische Vorgänge im Hintergrund, die WUWT zum Stop zwangen? Nein, keines von beidem, beruhigte Anthony die Blogosphäre vorab. Aber man müsse noch Geduld haben.