Eines der großen Probleme der erneuerbaren Energien ist der noch immer fehlende hoch-volumige Energiespeicher. An einem sonnig-windigen Tag könnten Solaranlagen und Windmühlen doch mal so richtig zeigen, was sie eigentlich drauf haben und kräftig Strom auf Vorrat produzieren. Denn eins ist gewiss: Der Wind macht in Deutschland auch mal Pause und die düsteren Herbsttage werden kein Zuckerschlecken für die Solarbauern. Leider ist die Vorratsenergieproduktion durch Wind und Sonne im großen Stil technisch bislang noch nicht möglich.

Die Forschung hierzu läuft hierzu jedoch auf Hochtouren. Ein interessanter Ansatz ist die Erzeugung von Methanol als umweltfreundlicher Treibstoff für Verbrennungsmotoren. Ausgangsstoffe hierfür wären CO2 und Wasserstoff. Das Kohlendioxid ließe sich in Kohlekraftwerken abscheiden und der Wasserstoff könnte zum Beispiel mithilfe von überschüssigem Strom von Wind- oder Solarkraftanlagen erzeugt werden.

Die Süddeutsche Zeitung berichtete hierzu am 30.7.2012:

Methanol könnte einfach in der existierenden Infrastruktur von Tanks und Tankwagen gespeichert werden; die Flüssigkeit ist bereits ein Grundstoff der Chemieindustrie, aus dem zum Beispiel Formaldehyd erzeugt wird. Mit ähnlichen Argumenten treiben seit einigen Jahren Entwickler die Hersteller von „Windgas“ an, bei der aus überschüssigem Strom erst Wasserstoff und dann mit CO2 Methan gemacht wird, das sich wie Erdgas benutzen lässt. Bei beiden Ansätzen geht viel Energie für die Umwandlungen und chemische Prozesse verloren. Sie ergeben daher nur Sinn, wenn die Zutaten quasi kostenlos sind. Das könnte der Fall sein, wenn die Windräder – oder auch Solarmodule – sonst abgeschaltet werden müssten, weil ihr Strom wegen eines Überangebots gerade nicht verbraucht werden kann und sogar die Stabilität des Stromnetzes gefährdet. Und wenn CO2 als Abfallprodukt in der Zementherstellung, im Kohlemeiler oder idealerweise bei der Erzeugung von Biogas abfällt.

CO2 als einer der Ausgangsstoffe für nachhaltige Energieträger: Dies ist sicher vernünftiger als die Versenkung im Untergrund, insbesondere wenn die Klimawirkung des Kohlendioxids deutlich geringer ist als bislang vom IPCC angenommen. Zudem ist die CO2-Versenkung in Deutschland offenbar auch gar nicht durchsetzbar, was jetzt auch Bundesumweltminister Peter Altmaier nochmals bestätigte (SZ vom 25.7.2012):

Für die unterirdische Speicherung von Kohlendioxid sieht es in Deutschland schlechter aus denn je. Am [23.7.2012] hatte Bundesumweltminister Peter Altmaier (CDU) in der Saarbrücker Zeitung klargestellt, dass CO2-Einlagerung im Boden gegen den Willen der Bevölkerung nicht durchzusetzen sei – und momentan ist nicht absehbar, dass die Technologie in der Bevölkerung beliebter wird.

Neben Methanol/Methan gibt es eine ganze Reihe weiterer potentieller Energiespeicherverfahren, die sich in der Erforschung befinden. Eines davon ist Carbazol, über das nordbayern.de kürzlich berichtete:

Nachdem sich die Temperatur seit 14 Jahren nicht mehr an die IPCC-Vorgaben hält, haben sich die Anhänger der Klimakatastrophe ein neues Betätigungsfeld gesucht, nämlich das Extremwetter. Dieser Bereich hat einige Vorteile. Seit jeher wird die Erde regelmäßig von Gewittern, Überschwemmungen, Dürren und Waldbränden heimgesucht. Jedes Jahr gibt es auf der ganzen Welt zahlreiche dieser Ereignisse, so dass es stets einen guten Aufhänger für das Schüren der Extremwetterangst gibt. Das Thema ist zudem ausreichend gruselig, so dass die Medien gerne darüber berichten. Und wer könnte an diesem Wetterchaos wohl Schuld haben? Natürlich, es muss ja wohl der alles kontrollierende Mensch sein, wer denn sonst. Beim nächsten Gewitter sollten wir uns daher ernsthaft Gedanken darüber machen, wie wir unser Benehmen auf dieser Erde verbessern könnten, damit wir in Zukunft von derlei atmosphärischen Strafen verschont bleiben. So oder so ähnlich wird es uns jedenfalls immer erzählt.

Nachdem sich die Temperatur seit 14 Jahren nicht mehr an die IPCC-Vorgaben hält, haben sich die Anhänger der Klimakatastrophe ein neues Betätigungsfeld gesucht, nämlich das Extremwetter. Dieser Bereich hat einige Vorteile. Seit jeher wird die Erde regelmäßig von Gewittern, Überschwemmungen, Dürren und Waldbränden heimgesucht. Jedes Jahr gibt es auf der ganzen Welt zahlreiche dieser Ereignisse, so dass es stets einen guten Aufhänger für das Schüren der Extremwetterangst gibt. Das Thema ist zudem ausreichend gruselig, so dass die Medien gerne darüber berichten. Und wer könnte an diesem Wetterchaos wohl Schuld haben? Natürlich, es muss ja wohl der alles kontrollierende Mensch sein, wer denn sonst. Beim nächsten Gewitter sollten wir uns daher ernsthaft Gedanken darüber machen, wie wir unser Benehmen auf dieser Erde verbessern könnten, damit wir in Zukunft von derlei atmosphärischen Strafen verschont bleiben. So oder so ähnlich wird es uns jedenfalls immer erzählt. Wir haben an dieser Stelle bereits des Öfteren über das Extremwetter berichtet (siehe Artikelübersicht

Wir haben an dieser Stelle bereits des Öfteren über das Extremwetter berichtet (siehe Artikelübersicht

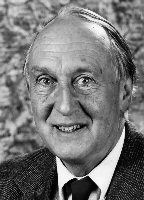

Kenneth Hsü ist ein ganz außergewöhnlicher Geologe. Als die Geowissenschaften das Land verließen und damit begannen, die Geheimnisse der Ozeanböden zu erkunden, war er in führender Funktion mit dabei. Hsü nahm im Laufe seiner Karriere an fünf wissenschaftlichen Ozeanbohrkampagnen teil die ihn in den Südatlantik, das Schwarze Meer und das Mittelmeer führten. Während seiner Laufbahn veröffentlichte Hsü mehr als 400 Arbeiten, darunter auch das bekannte populärwissenschaftliche Werk

Kenneth Hsü ist ein ganz außergewöhnlicher Geologe. Als die Geowissenschaften das Land verließen und damit begannen, die Geheimnisse der Ozeanböden zu erkunden, war er in führender Funktion mit dabei. Hsü nahm im Laufe seiner Karriere an fünf wissenschaftlichen Ozeanbohrkampagnen teil die ihn in den Südatlantik, das Schwarze Meer und das Mittelmeer führten. Während seiner Laufbahn veröffentlichte Hsü mehr als 400 Arbeiten, darunter auch das bekannte populärwissenschaftliche Werk  Zum Abschluss unserer kleinen Modellierungsreihe werfen wir heute einen Blick zurück in die Frühphase der Klimawandelprognostik. Wir schreiben das Jahr 1974. Die globale Durchschnittstemperatur war seit einem Wärmemaximum um 1940 leicht abgefallen. Der Sommer in Deutschland fiel buchstäblich ins Wasser. Die mit Gletschern und Packeis bedeckte Fläche auf der nördlichen Halbkugel wuchs stetig an.

Zum Abschluss unserer kleinen Modellierungsreihe werfen wir heute einen Blick zurück in die Frühphase der Klimawandelprognostik. Wir schreiben das Jahr 1974. Die globale Durchschnittstemperatur war seit einem Wärmemaximum um 1940 leicht abgefallen. Der Sommer in Deutschland fiel buchstäblich ins Wasser. Die mit Gletschern und Packeis bedeckte Fläche auf der nördlichen Halbkugel wuchs stetig an.

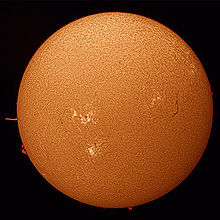

Ein Hauptproblem der diversen Klimamodelle ist die viel zu gering angenommene Klimawirkung der Sonne. Wie können die Temperaturen in den letzten 10.000 Jahren synchron zur Sonnenaktivität pulsiert haben, wenn doch die Sonne eigentlich kaum eine Rolle gespielt haben sollte? Dabei gibt es mindestens drei Stellschrauben, an denen die Modellierer nachbessern könnten. So werden derzeit keinerlei Solarverstärker berücksichtigt (siehe unser Buch „Die kalte Sonne, Kapitel 6). Weder der UV-Verstärker noch der Svensmark-Verstärker über die kosmische Strahlung und Wolken wurden bislang in Klimamodell-Szenarien umgesetzt.

Ein Hauptproblem der diversen Klimamodelle ist die viel zu gering angenommene Klimawirkung der Sonne. Wie können die Temperaturen in den letzten 10.000 Jahren synchron zur Sonnenaktivität pulsiert haben, wenn doch die Sonne eigentlich kaum eine Rolle gespielt haben sollte? Dabei gibt es mindestens drei Stellschrauben, an denen die Modellierer nachbessern könnten. So werden derzeit keinerlei Solarverstärker berücksichtigt (siehe unser Buch „Die kalte Sonne, Kapitel 6). Weder der UV-Verstärker noch der Svensmark-Verstärker über die kosmische Strahlung und Wolken wurden bislang in Klimamodell-Szenarien umgesetzt.