Von Frank Bosse und Fritz Vahrenholt

Unser Zentralgestirn war im Februar sehr unterdurchschnittlich aktiv. Die festgestellte SunSpotNumber (SSN) betrug nur 44,8, das sind etwa 53% des Durchschnittswertes aller bisher systematisch beobachteten Sonnenzyklen zu diesem Zyklusmonat.

Abb.1: Die Sonnenaktivität des aktuellen Zyklus 24 (Solar Cycle, SC) in rot, der Mittelwert aller bisher aufgezeichneten Zyklen in blau und der bis vor wenigen Monaten recht ähnliche SC1 in schwarz.

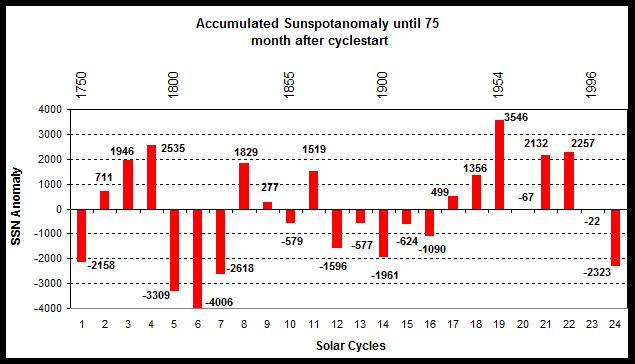

Seit dem Beginn des SC24 im Dezember 2008 sind nun 75 Monate verstrichen und „über alles“ erreichte dieser Zyklus ebenfalls nur 53% des Normalwertes. Vor ca. 22 Jahren (im November 1992) war der Zyklus 22 zeitlich ebenfalls im Monat 75 und da hatten wir eine Aktivität von 139% des Mittelwertes von Beginn an. Der schnelle Rückgang der Sonnenaktivität ist schon recht eindrucksvoll. Im Vergleich aller Zyklen untereinander wird das ebenfalls deutlich:

Abb.2: Der Vergleich aller Zyklen untereinander. Die Werte entstehen, indem die Differenzen der einzelnen Monate der Zyklen zum Mittelwert (blau in Abb.1) aufsummiert werden.

Die solaren polaren Magnetfelder haben sich auch etwas weiter aufgebaut im Vergleich zum Vormonat (vgl. Abb.2 in unserem Artikel „Die Sonne im Januar 2015 und atlantische Prognosen„) und damit ist das Fleckenmaximum nun definitiv Geschichte. Sehr wahrscheinlich sehen wir in den nächsten Jahren ein recht langsames weiteres Zurückgehen der Sonnenaktivität, schwache Zyklen, wie der aktuelle, sind auch oft überdurchschnittlich lang. So könnte das nächste Minimum, dessen Ende zeitlich definiert wird durch das erste Auftauchen von Flecken des neuen Zyklus 25 erst nach 2020 erreicht werden. Die Magnetfelder seiner Sonnenflecken sind dann umgekehrt angeordnet als die des jetzigen SC24.

Der Strahlungsantrieb von Klimamodelle ist nicht validierbar?

Ende Januar 2015 wurde die „Klimaszene“ durch eine Arbeit von Jochem Marotzke und Piers Forster in Nature erregt, die sich mit den Möglichkeiten der Bewertung von Klimamodellen hinsichtlich der Größe des Strahlungsantriebes („radiative Forcing“) durch Treibhausgase befasste. Über die seit etwa 10 Jahren immer größere Divergenz zwischen den beobachteten Temperaturen und den Modellprojektionen hatten wir ja recht oft berichtet (vgl. auch unseren Beitrag „Wie empfindlich ist unser Klima gegenüber der Erwärmung durch Treibhausgase?„). Nun also nahmen sich die Klimaforscher Jochem Marotzke und Piers Forster der Sache an und kommen zu dem Schluss, dass die hohe interne Variabilität unseres Klimas es bislang unmöglich macht, die Auswirkungen der in den einzelnen Modellen verschieden hoch berechneten Sensitivität gegenüber Treibhausgasen (Greenhouse Gases – GHG) zu überprüfen. Nach ihrer Auffassung können die Modelle also gar keinen Fehler machen und sind nicht im Mittel „zu empfindlich“ in der Bewertung der Erwärmung durch CO2 und anderen Treibhausgasen. Diese Schlussfolgerung ging dann sehr pointiert durch die Presse, in fast jedem Medium war so etwas zu lesen:“ Skeptikern, die immer noch am menschengemachten Klimawandel zweifeln, bricht nun eines ihrer letzten Argumente weg: Zwar gibt es eine Erwärmungspause, die Erdoberfläche hat sich seit der Jahrtausendwende also deutlich schwächer aufgeheizt, als sämtliche relevanten Klimamodelle vorhergesagt hatten. Die Kluft zwischen berechneter und gemessener Erwärmung entsteht aber nicht, weil die Modelle systematische Fehler machen, wie die Skeptiker vermutet hatten, sondern weil es im Klima stets zu zufälligen Schwankungen kommt.“

Der Satz stammt ursprünglich aus der Pressemitteilung der Max-Planck-Gesellschaft, ein in der Physik wirklich großer Name. Schon bald nach der Veröffentlichung der Arbeit in „Nature“, dem Journal mit dem weltweit höchsten Einfluss in den Naturwissenschaften, wurden Zweifel an der zitierten Folgerung laut. Nicholas Lewis veröffentlichte auf dem Blog „Climate Audit“ von Steve McIntyre ein Post indem er die Methoden und die Folgerungen scharf anging. Diese Wortmeldung hatte über 800 Kommentare zur Folge, die sich immer mehr verdichteten zu der Aussage, dass die Folgerungen in der Arbeit von Marotzke und Forster nicht gerechtfertigt sind. Kann man die Modelle doch bewerten und Aussagen darüber treffen, ob der Mittelwert aller Modelle die GHG-Wirkung überschätzt oder nicht? Wir wollen es versuchen!

Schritt 1:

Wir benutzen die Daten der Modelle, die freundlicherweise Wills Eschenbach zur Verfügung gestellt hat. In der Datenbasis sind 42 Modelle enthalten, die u.a. die globale Temperaturentwicklung bis 2100 projizieren. Die einzelnen Läufe sind dort anonym als „Serie 1 bis 42“ bezeichnet. Damit bestimmen wir die Steigerungsraten (die Trends) jeder einzelnen Reihe von 1900,1901 usw. bis 1995 mit dem konstanten Endjahr 2014.

Das gleiche berechnen wir für die beobachteten Temperaturen der Reihe HadCRUT4. Nun berechnen wir die jährlichen Differenzen (Residuen) zwischen jeder einzelnen Reihe und den Beobachtungen und summieren die quadrierten Werte für 1900, 1901 usw. für jede Reihe auf. Je kleiner diese „Quadratesumme der Residuen“ ist, desto kleiner ist die Abweichung zwischen der einzelnen Reihe und den Beobachtungen. Das ergibt für das Ensemble der 42 Reihen recht große Unterschiede:

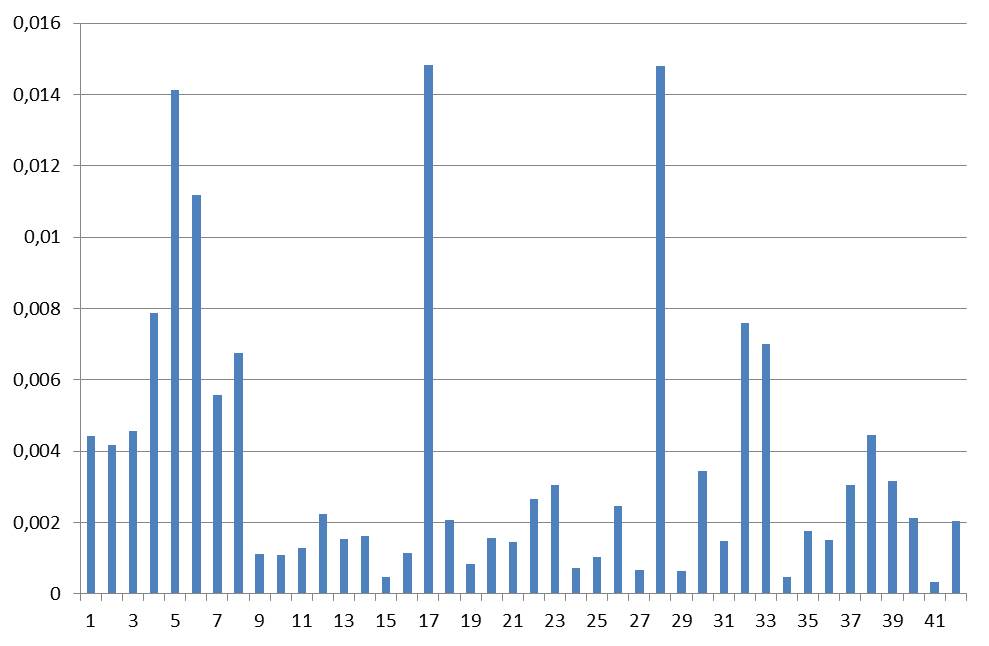

Abb. 3: Die Abweichungen zwischen Beobachtungen und modellierten Werten für die 42 Reihen der Datenbasis ( auf der X- Achse aufgetragen).

Schritt 2:

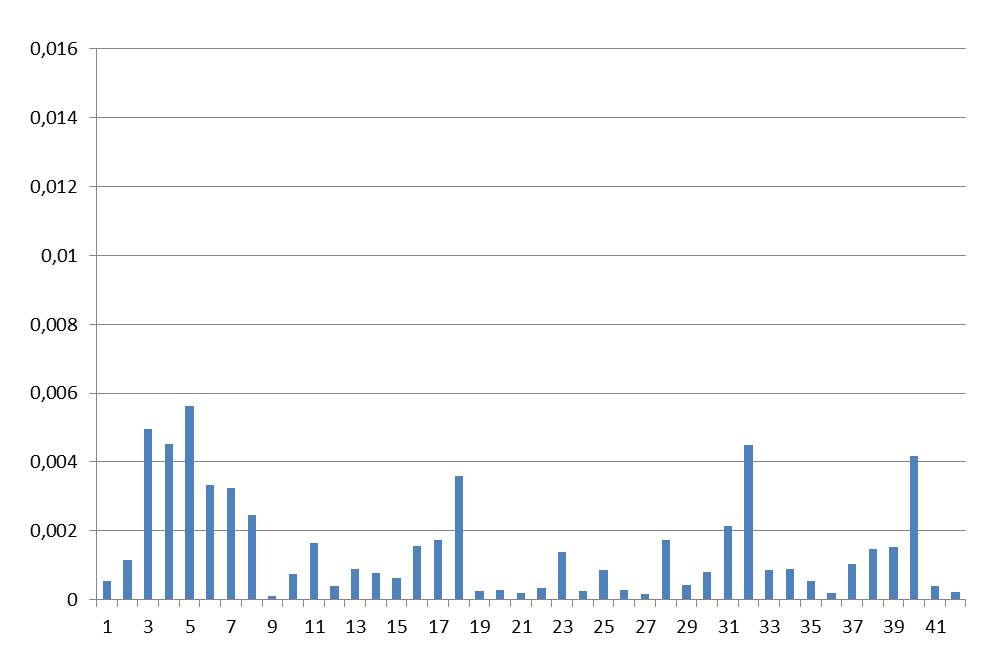

Wir wiederholen die gleiche Prozedur wie in Schritt 1 beschrieben, nur diesmal mit den Trends bis 2004, ein nur um 10 Jahre vorverlegtes Ende jeder Trendreihe.

Abb.4: Die Quadratesummen der Residuen für die Trends von 1900, 1901 usw. bis 1985 mit dem konstanten Endjahr 2004. Der Maßstab der Ordinate ist der gleiche wie in Abb. 3.

Es fällt auf, dass die Fehler für die Trends bis 2004 im Mittel sehr deutlich kleiner sind (Abb.4) als für die Trends bis 2014 (Abb.3). Das kann nicht verwundern, die Parameter der meisten Modelle wurden für den Zeitraum bis 2005 „eingestellt“. Daher ist die Abbildung der Trends der Modelle bis 2004 auch gut übereinstimmend mit den Beobachtungen:

Abb.5: Der Trend des Modellmittels (Mod. Mean, rot ) in Grad C/ Jahr von 1900, 1901 usw. bis 1985 mit dem konstanten Endjahr 2004 im Vergleich zu den Beobachtungen (Obs, schwarz).

Offensichtlich „hält“ die Einstellung der Modellparameter nicht mehr, die Fehler bis zum Jahr 2014 nehmen sehr zu.

Schritt 3:

Wir berechnen die Quotienten des Fehlers des Trends bis 2014 dividiert durch den Fehler des Trends bis 2004 für jede einzelne der 42 Reihen der Datenbasis und machen einen 2-dimensionalen Vergleich:

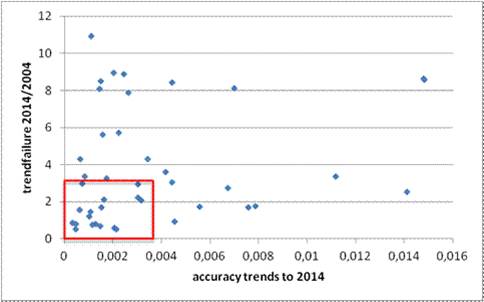

Abb. 6: Die einzelnen Reihen als Punkte. Die Koordinaten werden bestimmt durch die Fehler der Trends bis 2014 (X- Achse) und dem Verhältnis der Fehler bis 2014/2004 (Y- Achse). Das rote Rechteck markiert die „Grenzen“, die „guten“ Reihen sind innerhalb, die „schlechten“ außerhalb.

Das Koordinaten des roten Rechteckes werden durch die Standardabweichung der beiden Reihen gebildet, die Reihe der Fehler der Trends bis 2014 (vgl. Abb. 3) haben eine von 0,0038 Grad/Jahr, die Quotienten aus den Fehlern bis 2014 dividiert durch den Fehlern bis 2004 (vgl. Abb. 4) haben eine von 3,1.

Schritt 4:

Wir bestimmen den Mittelwert der Trends für jedes einzelne Jahr 1900, 1901 usw. bis zum konstanten Endjahr 2014 NUR aus den Reihen, die innerhalb des roten Rechtecks in Abb. 6 liegen. Wir filtern damit nach 2 Gesichtspunkten: Eine Serie soll a) möglichst einen geringen Fehler in der Trendberechnung bis 2014 machen und b) soll möglichst stabil auch bei unterschiedlichen Zeitintervallen sein.

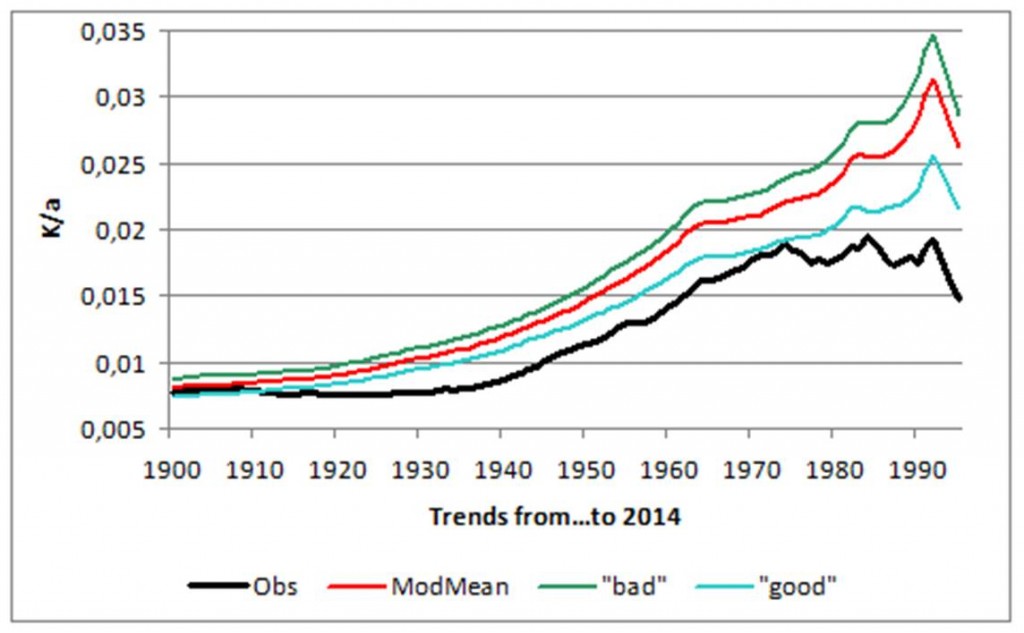

Abb. 7: Die laufenden Trends von 1900, 1901 usw. bis zum konstanten Endjahr 2014 in Grad/Jahr.

In rot: Das Modellmittel, in blau die in Abb. 6 herausgefilterten „guten“, in grün die in Abb. 6 bestimmten „schlechten“ (außerhalb des roten Rechtecks da) und in schwarz die Beobachtungen. Die „guten“ Reihen liefern im Mittel einen deutlich reduzierten Fehler im Vergleich zum Mittel. Die „schlechten“ zeigen die schlechteste Leistung wenn man alle drei in Relation zu den Beobachtungen setzt.

Bis zu diesem Zeitpunkt kannten wir die Namen der Modelle hinter den „Reihen“ der Datenbasis nicht. Dank der Hilfe von Willis Eschenbach und Nic Lewis erfuhren wir erst jetzt die Zuordnung und die Eigenschaften der Modelle hinter den „Reihen“, auch deren jeweilige Empfindlichkeit gegenüber dem Antrieb durch GHG. Der Mittelwert der „guten“ für die TCR ( Transient Climate Response), einem Ausdruck für die berechnete Teibhausgaswirkung, beträgt für die „guten“ ca. 1,6, für den Mittelwert aller Modelle 1,8 und für die „schlechten“ ca. 1,95. Wie Sie in Abb. 7 sehen, „verbessert“ die Auswahl der „guten“ Modelle die Näherung zu den Beobachtungen. Für diese wird eine TCR von ca. 1,3 angenommen, vergleichen Sie mit unserem Beitrag „Wie empfindlich ist unser Klima gegenüber der Erwärmung durch Treibhausgase?„.

Folgerung

Die Modelle überschätzen den Antrieb durch Treibhausgase im Mittel, die objektiv besseren Modelle rechnen ihn niedriger als die objektiv schlechteren. Viele Modelle sind „überangepasst“ an den Zeitraum bis 2005, sie zeigen danach einen dramatischen Verlust an Vorhersagequalität. Marotzke und Forster hatten Unrecht? Ob wir es je aus ihrem Munde erfahren werden? Zweifel sind angebracht.